de Jesús Ruiz

Hace unos días el diario El País publicaba una entrevista a Paul Krugman. En la primera de las preguntas el premio Nobel respondía: “[…] básicamente no encontrará economistas honestos que digan que una rebaja de impuestos se va a pagar sola [como prometió Donald Trump con su gran recorte fiscal]. Tenemos muchos ejemplos de que no es así, pero la gente lo sigue diciendo.”

Hace unos días el diario El País publicaba una entrevista a Paul Krugman. En la primera de las preguntas el premio Nobel respondía: “[…] básicamente no encontrará economistas honestos que digan que una rebaja de impuestos se va a pagar sola [como prometió Donald Trump con su gran recorte fiscal]. Tenemos muchos ejemplos de que no es así, pero la gente lo sigue diciendo.”

Unas semanas antes, Olivier Blanchard había declarado ante el Comité de Presupuestos de la Cámara de Estados Unidos (House Budget Committee; véase aquí) que, de alguna manera, las políticas de gasto en favor del medio ambiente “se pagan solas”; en la medida que, en efecto, mejoran el futuro. Su argumento destacaba, además, que dichas políticas deberían ser financiadas con impuestos pero también con deuda aprovechando que vivimos en un mundo con tipos de interés bajos. Más concretamente, en su documento de hace un año “Public Debt and Low Interest Rates” (véase aquí o en un resumen aquí, o en este post de Marcel y Juan Francisco), Blanchard afirmaba que si los costes de la deuda son pequeños (debido a tipos de interés bajos, y que probablemente se mantendrán así en el futuro), los países no deberían ser penalizados por altos niveles de deuda per se siempre que el endeudamiento financie políticas de gasto que mejoren el futuro (por ejemplo, el caso de los bonos verdes). La dificultad, quizás, sería “re-educar” a las agencias de rating y a los inversores privados para que entendieran el valor de lo que podría denominarse “deuda buena.”

Ambos argumentos pueden ser racionalizados por la existencia de efectos de Laffer dinámicos de las políticas impositivas. Lamentablemente, sin embargo, la evidencia empírica sugiere que es muy difícil, si no imposible, incluso en presencia de estos efectos dinámicos, encontrar situaciones en que un recorte fiscal pueda autofinanciarse.

Conviene aclarar en primer lugar la diferencia entre un efecto Laffer dinámico, y el más popular efecto Laffer estático, basado éste en modelos estáticos, cuyas predicciones son más bien utilizadas como efectos de corto plazo. Uno de los temas más controvertidos del análisis de la política impositiva es aquél que estudia si un recorte impositivo impulsará la actividad económica, hasta el punto que el presupuesto público mejore tanto que el recorte fiscal se autofinanciará. Desde un punto de vista estático, los modelos tradicionales utilizados se basaban en estudiar si el tipo impositivo marginal se situaba en la parte decreciente de una curva como la representada en la Figura 1. En este gráfico, diríamos que bien conocido, se representan los niveles de un tipo impositivo (por ejemplo, un tipo impositivo sobre la renta del trabajo), frente a los ingresos generados por tal impuesto. El gráfico muestra que, para niveles bajos del tipo impositivo, un aumento pequeño del mismo no tendrá unos efectos demasiado negativos sobre los incentivos de los hogares a trabajar haciendo posible, por tanto, un aumento en los ingresos públicos (en nuestro ejemplo, la base imponible –renta del trabajo– no se vería muy reducida). Sin embargo, para valores altos del tipo impositivo, un aumento del mismo podría generar reducciones en los ingresos públicos debido a la caída de la base imponible resultante del desincentivo generado por un tipo impositivo elevado. Lamentablemente, y desde el punto de vista empírico para las economías desarrolladas, no parece haber figuras impositivas que se sitúen en la parte decreciente de tal Curva de Laffer Estática. No solo eso, sino que desde un punto de vista de implementación práctica, cualquier gobierno que reduzca impuestos esperando, en un hipotético futuro, los beneficios de la curva de Laffer estática, va a experimentar antes de eso los efectos dinámicos de los que vamos a hablar en este post y sobre los que no se suele pronunciar ningún heraldo de Laffer.

Figura 1. Curva de Laffer Estática

A diferencia de la curva de Laffer estática, la clave del efecto Laffer Dinámico es que un recorte impositivo puede afectar positivamente a la tasa de crecimiento de la economía. Si la reducción en el tipo impositivo da lugar a un incremento suficientemente importante en la tasa de crecimiento, de manera que la base imponible futura se incrementa en el largo plazo, entonces es posible que los ingresos fiscales futuros den lugar a superávits que compensen los déficits iniciales creados con el recorte impositivo. Es decir, es posible que el recorte impositivo pueda pagarse solo, y aunque el tipo impositivo se encuentre en la parte creciente de la curva de Laffer estática.

En definitiva, podemos hablar de un recorte impositivo dinámicamente factible si los déficits iniciales generados por tal recorte, se compensasen con superávits futuros en valor presente (es decir, la restricción presupuestaria del gobierno se satisface intertemporalmente).

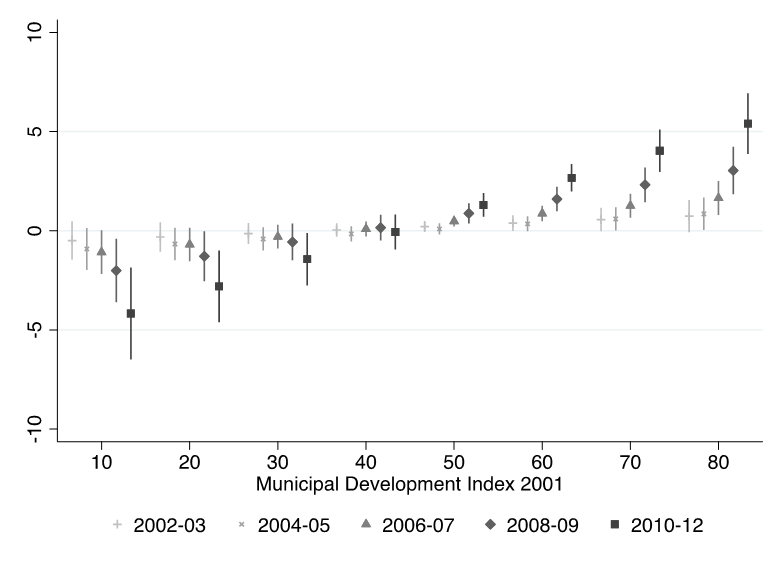

Es muy importante tener en cuenta que, para que pueda existir un recorte impositivo dinámicamente factible, es imprescindible que tras el recorte impositivo el gobierno mantenga sus programas de gasto originales (consumo público o transferencias), de manera que sigan creciendo a la misma tasa que antes del recorte. La Figura 2 ilustra este argumento. En la figura representamos el tiempo en el eje horizontal, y en el eje vertical las sendas temporales de los ingresos públicos (línea roja) y de los gastos públicos (línea azul). Para simplificar, suponemos equilibrio presupuestario hasta el instante t0 (los ingresos públicos se igualan a los gastos públicos, esto es, ambas líneas se solapan). En t0, sin embargo, se produce el recorte impositivo, lo que provocará una caída en los ingresos públicos actuales (esto es, estamos en la parte creciente de una hipotética curva de Laffer estática), generando un déficit presupuestario, que se financiará mediante la emisión de deuda pública.

Si el recorte impositivo resulta en que la base imponible (renta del trabajo, por ejemplo) crezca a una mayor tasa, llegará un momento en que los ingresos públicos superarán al gasto público generándose superávits presupuestarios a partir de t1. La factibilidad de tal recorte exige que el área en A sea menor que el área en B en valor presente (de nuevo, la suma descontada de los ingresos públicos menos la suma descontada de los gastos públicos debe ser mayor o igual que cero, es decir, la restricción presupuestaria del gobierno se satisface intertemporalmente). Conviene tener en cuenta que, a medida que pasa el tiempo, el valor presente de los gastos y de los ingresos es menor, por lo que el área B (más alejada en el tiempo) aporta un valor menor que el área A (más próxima). También hay que advertir que, aunque el recorte pudiera ser factible, lo cual equivale a decir que el nivel de deuda generado por tal recorte se acabará amortizando en el largo plazo, tales niveles de endeudamiento sobre PIB podrían llegar a ser muy altos durante la transición, con todos los inconvenientes que generarían en los mercados de deuda.

En definitiva, la factibilidad del recorte impositivo depende: i) del efecto del tipo impositivo sobre la tasa de crecimiento (a mayor efecto, menor será el número de periodos con déficit); ii) de la pérdida inicial de ingresos ocasionada por el recorte impositivo (la sensibilidad de la recaudación respecto del impuesto); y iii) del efecto de equilibrio general sobre el tipo de interés real neto de impuestos con el que se descuentan ingresos y gastos futuros.

Figura 2.

Por supuesto, definir programas de gasto del gobierno (consumo público y transferencias) que mantienen el mismo porcentaje sobre el PIB (en lugar de crecer a la tasa más baja de antes del recorte impositivo), es incompatible con un efecto Laffer dinámico (tanto los ingresos como los gastos crecerán a igual tasa tras el recorte impositivo). Es decir, es crucial cómo definamos la política de gasto del gobierno. En todo caso siempre puede ser interesante valorar qué proporción de un recorte impositivo puede autofinanciarse, comparando para ello el déficit inicial creado, con el déficit intertemporal de largo plazo alcanzado.

¿Por qué la mayoría de los economistas son escépticos sobre que un recorte impositivo pueda autofinanciarse, como decía Krugman? Dicho de otra manera, ¿a qué dificultades se enfrenta la existencia de figuras impositivas que den lugar a un efecto Laffer dinámico? Principalmente cuatro:

i) Los estudios empíricos sugieren que los efectos de los recortes impositivos sobre la tasa de crecimiento a largo plazo son pequeños. Además, es conveniente hacer notar que si en algún periodo un recorte fiscal generó más ingresos, este hecho casual no puede indicar causalidad a menos que se demuestre que el crecimiento de la base imponible fue debida al recorte fiscal y no a otros factores. Identificar qué proporción de un mayor crecimiento se debe al recorte fiscal no es nada fácil, siendo tal identificación una de las cuestiones más abiertas y controvertidas en el análisis macroeconómico cuantitativo. Así, el pasado 10 de febrero, el diario El Mundo, sección Andalucía, publicaba una noticia con el siguiente titular “Sube la recaudación en 2019 pese a la bajada de impuestos”. Nótese que este titular no demuestra que el mayor crecimiento de la renta o de la actividad económica en Andalucía en 2019 (y, por tanto, de la base imponible) fuera provocado por los recortes impositivos realizados. De ahí que, en la misma noticia, apareciera la siguiente afirmación en la línea que comentábamos más arriba: “[…] lo que está por determinar es si la recaudación hubiese sido diferente (mayor o menor) de no haberse producido la reforma fiscal de 2019.”

Por otro lado, desde un punto de vista teórico, los tipos impositivos tendrán mayores efectos sobre la tasa de crecimiento si la elasticidad de sustitución intertemporal (ESI) del consumo privado es alta (esto es, si la elasticidad del ahorro respecto al tipo de interés es alta). El problema es que una ESI alta hace que el modelo teórico no pueda replicar sendas de consumo suaves como las observadas en los datos (dónde la volatilidad asociada al componente cíclico del consumo privado es menor que la volatilidad asociada al componente cíclico del PIB). En consecuencia, los modelos teóricos tienen dificultad para generar efectos Laffer dinámicos bajo niveles de la ESI empíricamente plausibles (véanse Agell y Persson, 2001, Novales y Ruiz, 2002, y Bruce y Turnovsky, 1999).

ii) Para que un recorte impositivo financiado con deuda tenga éxito debe suponerse perfecta credibilidad de la autoridad fiscal. Si los agentes piensan que va a ser imposible que un recorte impositivo se autofinancie, esperarán que en el futuro el gobierno no tenga más remedio que subir impuestos para pagar los déficits generados. Ante esa expectativa los agentes tomarán hoy decisiones de consumo y ahorro inesperadas para el gestor de la política, y previsiblemente los efectos dinámicos de Laffer no llegarán a producirse.

iii) Si los recortes impositivos provocan incrementos en los tipos de interés netos de impuestos con los que se valoran los ingresos y gastos públicos futuros, los superávits presupuestarios futuros tendrán un valor muy bajo respecto de los déficits iniciales, lo que hará difícil un recorte dinámicamente factible. Con tipos de interés bajos, esta dificultad pierde importancia, como ha hecho ver Olivier Blanchard, en los términos que reflejábamos al principio.

iv) Si, aún así, existe algún recorte dinámicamente factible, la senda de endeudamiento puede conducir a niveles de deuda sobre PIB elevados durante la transición, tanto, que sean penalizados por inversores privados y agencias de rating. Es por ello que Blanchard insistía en re-educar a los mercados para discriminar “endeudamiento bueno” (endeudarse para pagar políticas de lucha contra el cambio climático) de “endeudamiento malo”. Por supuesto, podemos evaluar tanto recortes impositivos como incrementos en alguna partida de gasto que puedan pagarse con deuda, y que tenga efectos sobre el crecimiento como para generar algún efecto Laffer dinámico (piénsese, por ejemplo, en pagar con impuestos y con deuda subsidios a tecnologías limpias, que puedan incrementar el crecimiento económico).

En definitiva, tanto teórica como empíricamente, parece difícil encontrar situaciones económicas y figuras impositivas cuyo recorte pueda autofinanciarse, ya sea desde un punto estático o dinámico. Es por esto, en gran parte, que Krugman argumentaba que era difícil encontrar un economista honesto que dijera que una rebaja fiscal pudiera pagarse sola. Lo cierto es que los modelos de crecimiento endógeno que se han usado para analizar los efectos Laffer dinámicos no presentan propiedades empíricas adecuadas como para convertirse en laboratorios fiables de evaluación de políticas, (algo que sucede también con muchos otros modelos neo-keynesianos sin crecimiento, o con crecimiento exógeno). Esto deja abierto el debate sobre cómo evaluar efectos Laffer en modelos de crecimiento endógeno con mejores propiedades empíricas, en los que podrá estudiarse cómo de sensibles son los efectos Laffer encontrados a las características estructurales de las economías modelizadas (sobre preferencias, tecnología, rigidez de precios y salarios,…), información ésta muy relevante para los gestores de la política fiscal.

Una respuesta de la literatura ha sido la de utilizar modelos neoclásicos o neo-keynesianos para estudiar en qué porcentaje un recorte impositivo puede autofinanciarse. Para ello se comparan los efectos contemporáneos frente a los efectos a largo plazo que tal recorte impositivo tiene sobre los ingresos públicos, en lo que se ha dado en llamar Dynamic Scoring (véase Mankiw y Weinzierl, 2006, o Trabandt y Uhlig, 2011). En este caso, la cuestión abierta será la magnitud del efecto dynamic scoring para diferentes figuras impositivas objeto de recortes.

Referencias

Agell, Jonas and Mats Persson, (2001), “On the analytics of the dynamic Laffer curve”, Journal of Monetary Economics, 48(2), 397-414.

Bruce, Neil and Stephen J Turnovsky (1999), “Budget Balance, Welfare, and the Growth Rate: "Dynamic Scoring" of the Long-Run Government Budget”, Journal of Money, Credit and Banking, 31(2), 162-86.

Mankiw N.G., Weinzierl, M. (2006), “Dynamic Scoring: A Back-of-the-Envelope Guide”, Journal of Public Economics, 90 (8-9), 1415-1433.

Novales, A., and J. Ruiz, 2002, "Dynamic Laffer Curves", Journal of Economic Dynamics and Control, 27, 181-206.

Trabandt, Mathias and Harald Uhlig (2011), “The Laffer curve revisited”, Journal of Monetary Economics, 58(4), 305-327.

Use the Rubik's Cube solver here and it will fix your scrambled puzzle for you! Just set the scrambled colors and let the program find the solution for you.

Pedro Tedde de Lorca falleció el pasado sábado 9 de febrero a la edad de 75 años. Piero, como le llamaban su familia y sus más cercanos amigos, nació en Málaga de padre italiano (un ingeniero que vino a trabajar en la electrificación de Málaga) y madre española, de origen granadino. Piero ha sido uno de nuestros más sobresalientes historiadores económicos, especialista en historia bancaria y de la Hacienda Pública, universitario, académico y durante muchos años miembro del Servicio de Estudios del Banco de España (hoy Dirección General de Economía y Estadística).

Pedro Tedde de Lorca falleció el pasado sábado 9 de febrero a la edad de 75 años. Piero, como le llamaban su familia y sus más cercanos amigos, nació en Málaga de padre italiano (un ingeniero que vino a trabajar en la electrificación de Málaga) y madre española, de origen granadino. Piero ha sido uno de nuestros más sobresalientes historiadores económicos, especialista en historia bancaria y de la Hacienda Pública, universitario, académico y durante muchos años miembro del Servicio de Estudios del Banco de España (hoy Dirección General de Economía y Estadística).

Creo que no exagero cuando digo que de un tiempo a esta parte tenemos a la

Creo que no exagero cuando digo que de un tiempo a esta parte tenemos a la